La potente irruzione dell’intelligenza artificiale (=IA) nella nostra vita quotidiana ha cominciato a suscitare, insieme a grandi attese, pressanti interrogativi su questa tecnologia innovativa che, a detta di alcuni, potrebbe addirittura mettere a repentaglio l’esistenza stessa dell’umanità sul nostro pianeta [1]. Insomma, si fa sempre più necessaria un’algoretica, per riprendere il popolare neologismo coniato da P. Benanti [2], cioè una riflessione approfondita e aggiornata sulle possibilità e i rischi dell’IA che non sia monopolio dei soli addetti ai lavori.

Un semplice esperimento mentale

Per capire un po’ più da vicino quali sono le questioni che si affrontano parlando di etica dell’IA, possiamo fare un semplice esperimento mentale. Supponiamo di essere degli ingegneri o degli informatici che hanno il compito di progettare un sistema in grado di agire eticamente: il problema da risolvere è dunque quello di far comprendere in qualche modo l’etica alla nostra macchina e farla agire di conseguenza. La prima domanda che dovremmo porci è la seguente: che cos’è un fatto morale? O, in alternativa: esistono fatti o eventi che possono dirsi propriamente morali? Possono sembrare domande curiose; però, in effetti, è il primo scoglio da affrontare se dobbiamo insegnare a un “qualcosa” ad agire secondo canoni etici.

Insegnare l’etica a una macchina

Il tentativo di trovare la risposta a tali interrogativi è il compito di quel filone di studi che si chiama «metaetica» [3] (letteralmente: al di là/oltre l’etica) e che indaga ciò su cui l’etica si fonda: quindi non solo se esistano fatti/eventi che possiamo definire morali e che caratteristiche debbano avere, ma anche le ragioni oggettive e soggettive che permettano giustificare un comportamento definito “etico” (epistemologia e psicologia morale), e così via. La metaetica è quindi il primo grande ambito di riflessione nel campo dell’etica dell’IA.

Ora, supponiamo che per noi ingegneri “etici” esistano fatti che possono essere in qualche modo definiti morali. A questo punto si presenterebbe il problema di “insegnare” il comportamento morale a un algoritmo, quindi a una struttura di regole che agisce in modo puramente automatico. Non c’è, in effetti, molto spazio per riflettere di coscienza o altro: il nostro obiettivo è quello di arrivare a un comando che imponga alla macchina di fare qualcosa o di non farlo. Etica, quindi, per noi ingegneri “morali” sarebbe di tipo prettamente «normativo», vale a dire un insieme di regole che ci permettano di giungere a una decisione chiara e distinta: fai questo, evita quello.

Siamo quindi nel settore più “applicativo” dell’algoretica, quello dell’implementazione di un sistema etico, e anche qui le possibilità sono diverse: potremmo costruire una macchina “consequenzialista”, cioè che, letteralmente, calcoli le conseguenze del proprio agire (ad esempio usando una funzione matematica che pesi danni e benefici) e sulla base di questi conti decida (cioè calcoli) se compiere o meno una certa azione; oppure, potremmo implementare un algoritmo “deontologista”, ossia che abbia incorporati dei valori morali fondamentali sotto forma di criteri generali dell’agire (come le leggi della robotica di Asimov [4]) e sulla base di questi decida (cioè calcoli) se agire o meno; o, ancora, potremmo predisporre un dispositivo “casistico”, che sulla base di un repertorio di casi paradigmatici possa stabilire (cioè calcolare) se fare una certa cosa oppure no. Oppure, infine, si potrebbero mettere insieme questi tre approcci.

La novità dell’etica dell’IA

Deponiamo le vesti ingegneristiche e torniamo nel nostro mondo. Abbiamo tratteggiato in maniera molto sintetica, e anche un po’ fantasiosa, quali possono essere i problemi filosofici e tecnici che si incontrerebbero nel tentativo di incorporare l’etica in un algoritmo. Ciò dovrebbe aiutarci a comprendere qual è il centro nevralgico (e la novità) della riflessione sull’etica dell’IA, ossia che la preposizione «della» tra etica e IA è da intendere in senso soggettivo: non abbiamo più problemi di ordine puramente applicativo, relativi all’uso che possiamo fare di un certo strumento, in quanto ora in campo ci sono dispositivi che possono essi stessi prendere decisioni ed evolvere nel loro comportamento oltre le specifiche previste dai progettisti. Questo è un problema tanto rilevante da essere anche oggetto del recente regolamento dell’UE in materia, l’AI Act [5] (Considerando 66).

Le macchine possono essere capaci di agire moralmente?

La domanda che ci poniamo ora, da un punto di vista questa volta teologico-morale, è la seguente: tale adattabilità dei dispositivi alle situazioni concrete in modalità non sempre prevedibili può essere intesa anche come una soggettualità morale?

Per rispondere occorre considerare che tipo di “intelligenza” sia l’IA, ossia un algoritmo. Quest’ultimo, infatti, non è altro che un insieme, anche molto complesso, di calcoli, e proprio l’estrema complessità degli odierni algoritmi di deep learning ha permesso di osservare veri e propri fenomeni di emergenza (ossia l’apparizione di abilità “nuove” da parte del dispositivo che non erano state preventivate dagli sviluppatori) e una grande versatilità che consente alla macchina di svolgere compiti fino a poco tempo fa impensabili per un agente meccanico.

Ma tra queste capacità c’è anche l’etica?

La coscienza e la libertà

Di fronte a una tale questione, un teologo non può che andare al cuore del fatto morale: la coscienza e, in particolare, la libertà.

A volte si scambia troppo frettolosamente l’indeterminazione dell’agire dell’IA, cioè la sua non previdibilità a priori, con il segno che il dispositivo possieda una capacità di agire libero. Ma si tratta di un miraggio. Anche se di enorme complessità, che coinvolge migliaia di miliardi di operazioni e parametri, un algoritmo non è altro che numeri e calcolo. A ogni passo, se potessero essere noti tutti i parametri del sistema (possibile in linea di principio, impossibile in pratica), l’algoritmo sarebbe perfettamente prevedibile nel suo output, in quanto determinato. Infatti, niente esprime la necessità più dei calcoli matematici.

Il vero problema sta nella nostra incapacità cognitiva di gestire una tale complessità – ed è una questione di non poco conto – ma ciò non toglie il punto fondamentale: ogni algoritmo è deterministico, è necessità, in quanto puro calcolo. Quindi non c’è spazio per una genuina libertà e, ancor meno, per un’autentica coscienza. Al massimo, esso può manifestarne un’apparenza, e questa può essere davvero molto convincente.

Ricordiamo, inoltre, che anche se nella tradizione teologica si può parlare di ragionamento morale, questo però non si configura come un sillogismo, e ancora meno come un calcolo matematico ([6]). Per cui, “installare” l’etica in un dispositivo non ci sembra molto fattibile, se non, al massimo, in via approssimativa – utile certamente, ma niente di più, almeno allo stato attuale della tecnologia e degli approcci odierni.

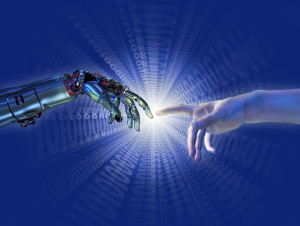

La persona al centro

Ciò suggerirebbe, pertanto, di usare prudenza nell’impiego di dispositivi a elevata automazione in ambiti a elevato impatto etico (si pensi alla guida autonoma o alla medicina), privilegiando approcci human-in-the-loop, in cui cioè la supervisione dei processi e le decisioni ultime sono in mano agli esseri umani. Ma, soprattutto, occorre resistere alla tentazione di sostituire il contatto umano, non sempre facile e scontato, con la rassicurante apparenza di un robot che sembra agire in modo empatico, come se ci capisse al volo, quando invece non sarebbe altro che la versione tecnologicamente avanzata e interattiva di un semplice specchio.

Il ruolo della riflessione teologica

Di algoretica, quindi, ossia di valutazione critica delle implicazioni antropologiche ed etiche che può avere questa nuova tecnologia, c’è bisogno, eccome, e questo lo sottolinea anche Papa Francesco nel suo messaggio per la giornata mondiale della pace di quest’anno [7] (n.6).

È vero che alcuni addetti ai lavori hanno iniziato a prendere sul serio e a parlare di un’IA “senziente”, che manifesterebbe le prime scintille di una coscienza di tipo umano. A questo riguardo è doveroso ricordare che a una preparazione tecnica altamente specialistica può benissimo accompagnarsi una disarmante ingenuità filosofica, specialmente quando per interpretare in maniera corretta certi fenomeni servirebbero competenze “umanistiche”.

Insomma, nel dibattito sull’IA c’è posto anche per la teologia!

Andrea Pizzichini, dopo una laurea specialistica in Ingegneria, ha conseguito la Licenza e il Dottorato in Teologia Morale presso l’Accademia Alfonsiana di Roma, dove attualmente è Professore invitato. Si occupa delle implicazioni etiche delle nuove tecnologie, in particolare nell’ambito dell’intelligenza artificiale e delle neuroscienze.

Lascia un commento